AI.Society: Robotik- und KI-Anwendungen der Zukunft

Ausstellung und Dialogplattform

Von Menschen für Menschen

Ob privat oder beruflich; gesellschaftlich oder wirtschaftlich: Robotik und Künstliche Intelligenz haben unser Leben grundlegend verändert – und werden dies auch weiterhin tun. Auf welche Bereiche wird sich der Einsatz innovativer Technologien besonders auswirken? Von welchen neuen Anwendungen werden wir zukünftig profitieren?

Neben konkreten Anwendungen für Arbeitswelt, Gesundheitswesen, Mobilität und Umwelt beleuchtet AI.Society auch ethische Fragestellungen rund um Robotik und KI. Weil der damit verbundene gesellschaftliche Wandel viele Chancen, aber auch neue Herausforderungen mit sich bringt. Umso wichtiger ist die konstruktive Gestaltung eines solchen Transformationsprozesses. Vertreter aus Wissenschaft, Wirtschaft, Politik und Gesellschaft entwickeln gemeinsam Visionen und Ansätze, wie dieser Prozess zu einer lebenswerten Zukunft beiträgt. Eine Zukunft, die immer auch die Gesellschaft mit einbezieht.

Die Fokusthemen

Zukunftsfeld Arbeit

Nichts beeinflusst und verändert den Arbeitsbereich so sehr wie die Entwicklung neuer Technologien und Produktionsmittel. Doch es hat ein Umdenken stattgefunden. So verfolgen die Forschungsexperten der Technischen Universität München (TUM) in ihrer Vision der Fabrik der Zukunft einen anderen Ansatz: den menschenzentrierten. Es geht darum, die Fähigkeiten des Menschen zu stärken, handwerkliche Möglichkeiten zu erweitern und eine sichere Arbeitsumgebung zu schaffen.

Das interdisziplinäre Netzwerk Work@MIRMI umfasst mehr als 20 Institute aus den Fakultäten Maschinenbau, Informatik, Automatisierungstechnik, Elektrotechnik, Bauwesen, Geographie, Umwelt, Sport und Gesundheit. Es erforscht Herausforderungen wie den demografischen Wandel, den Fachkräftemangel, den Klimawandel sowie die globale Wettbewerbsfähigkeit Europas. Eins ihrer Leuchtturmprojekte: die KI.FABRIK der Hightech-Agenda Bayern, die für eine krisensichere und profitable Produktion modernster IT- und mechatronischer Hightech-Komponenten bis zum Jahr 2030 umgesetzt werden soll. AI.Society bietet Ihnen vertiefende Einblicke in verschiedene Showcases.

SHOWCASES WORK 2025

Wir stellen ein System vor, mit dem Menschen Robotern neue Aufgaben beibringen können, ohne Programmierkenntnisse zu haben. Die Benutzer zeigen dem Roboter einfach, wie er etwas in einer einfachen Umgebung tun soll. Das System analysiert dann die menschliche Demonstration und erstellt eine flexible Abfolge von Handlungen (sogenannte „Fähigkeiten“), die der Roboter erlernen kann. Diese Fähigkeiten können später in komplexeren Situationen wiederverwendet werden. Dieser Ansatz macht die Roboterschulung schneller, intuitiver und auch für Menschen ohne technischen Hintergrund zugänglich.

Wir präsentieren ein System, das Menschen bei ferngesteuerten Industrietätigkeiten unterstützt – mithilfe eines „Digitalen Zwillings“, also einer virtuellen Kopie der realen Umgebung. In Kombination mit Künstlicher Intelligenz (genauer: Reinforcement Learning) lernt das System automatisch sogenannte „Virtuelle Führungshilfen“. Diese virtuellen Hilfen unterstützen Bediener dabei, präzise Montagearbeiten aus der Ferne einfacher und sicherer durchzuführen.

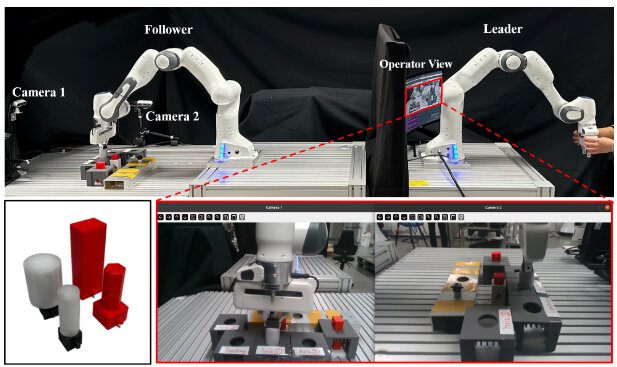

Unsere Demo stellt das Konzept des kollektiven Lernens vor – dabei lernen Roboter gemeinsam und teilen ihr Wissen miteinander. Ein kurzes, anschauliches Video erklärt den Ablauf auf einfache Weise. Anschließend zeigen zwei echte Roboter live, wie das im kollektiven Lernen erworbene Wissen auf ferngesteuerte Aufgaben (Teleoperation) übertragen werden kann.

Ein Digitaler Zwilling ist eine virtuelle Darstellung eines realen Systems, mit der sich Abläufe in Echtzeit überwachen, analysieren und optimieren lassen. In dieser Demo zeigen wir, wie unser Digitaler Prozesszwilling in einem BMW-Anwendungsszenario eingesetzt wird. Das System verknüpft Konstruktions- und Betriebsdaten über Plattformen wie Asset Administration Shell, Microsoft Azure und Omniverse. Besucher können aktiv mitmachen: Über Central.AI lassen sich individuelle Bestellungen aufgeben und der Produktionsfortschritt digital verfolgen. Auch Terminänderungen sind per Interaktion möglich.

Die steigende Nachfrage nach individuellen Produkten erfordert flexible Produktionsprozesse. In dieser Demo zeigen wir eine KI-gestützte Planungsmethode, die mit Hilfe sogenannter „Ontologien“ Aufgaben in der Fertigung effizienter organisiert. Die modulare Montagestation besteht aus einem Roboterarm mit vier verschiedenen Greifern und ist auf personalisierte Kleinserienproduktion ausgelegt. Ein Highlight: Fehlt ein Zahnradteil, kann ein Mitarbeiter oder ein Besucher das Teil übergeben, woraufhin der Roboter den Montageprozess sofort fortsetzt.

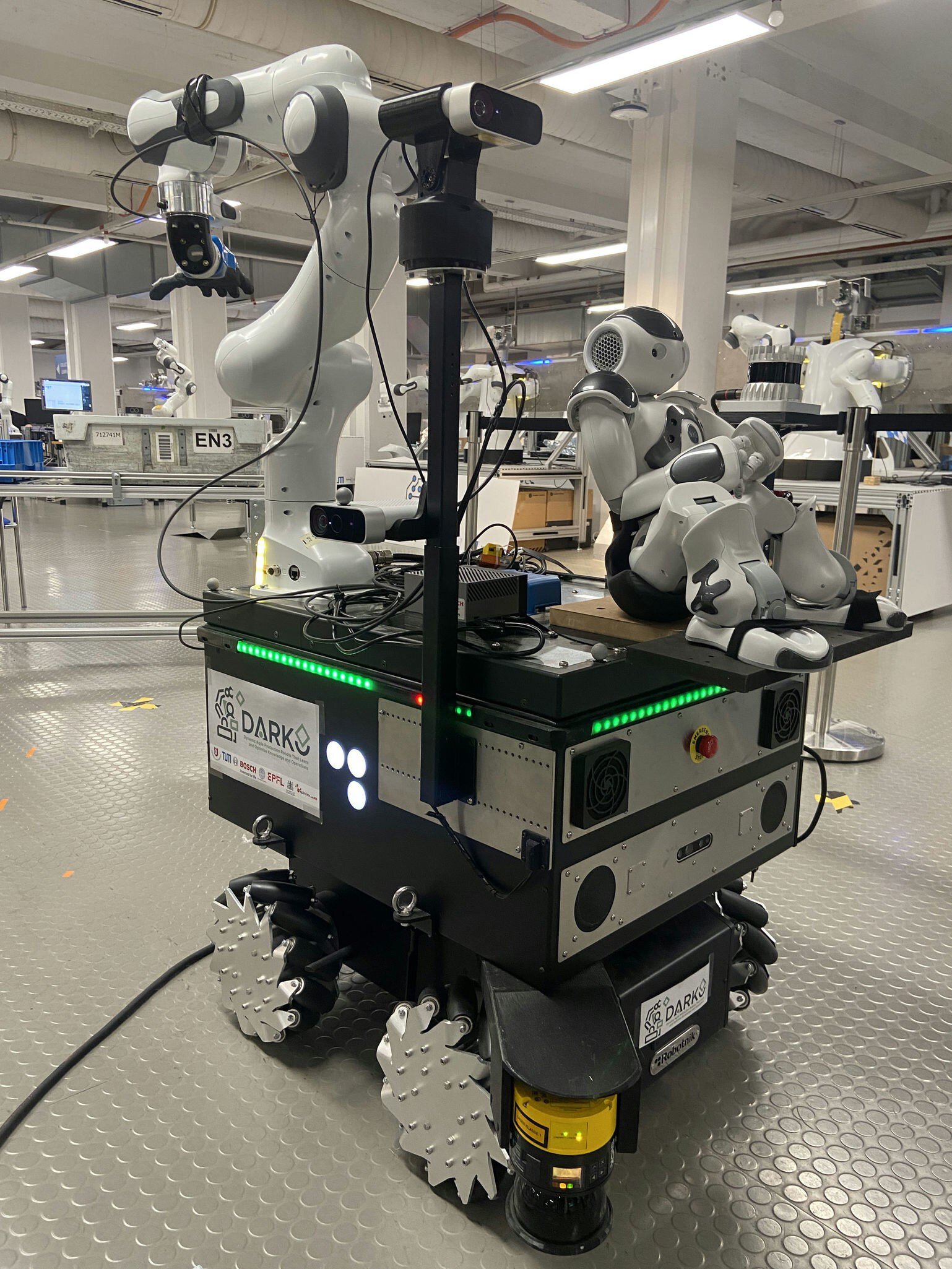

In dieser Demo arbeiten zwei Roboter zusammen, um anspruchsvolle Aufgaben zu meistern. Der MiR-Roboter übernimmt den Transport von Objekten und navigiert sicher durch die Umgebung. Er kann auch flexible und biegsame Materialien wie Kabel erkennen und handhaben – eine große Herausforderung für die Automatisierung. Der DARKO-Roboter arbeitet mit MiR zusammen und ist für das präzise Greifen und Manipulieren dieser Objekte zuständig.

Diese Demo zeigt, wie mehrere Roboter zusammenarbeiten, um ein Kabel zu verlegen – eine Aufgabe, die bisher meist manuell erfolgt. Zuerst wählt ein Roboter das passende Kabel aus einem Vorratsstapel. Danach wird das Kabel zwischen Roboterarmen koordiniert übergeben. Am Ende montieren die Roboter das Kabel präzise und befestigen es sicher. Die Handhabung von flexiblen Materialien wie Kabeln stellt eine große Herausforderung für die Automatisierung dar. Mit dieser Demo zeigen wir, wie Roboter auch solche Aufgaben übernehmen können.

In der klassischen Massenproduktion verteilen sich die Entwicklungs- und Designkosten auf viele gleiche Produkte. Doch in der Industrie 4.0 mit dem Trend zu individuell gefertigten Einzelstücken steigen diese Kosten stark an. Unsere Demo zeigt, wie Generative Künstliche Intelligenz (KI) helfen kann. Mit fortschrittlichen Bildgenerierungsmodellen und einem intelligenten Rückkopplungsprozess wird ein Design gemeinsam mit einem Menschen schrittweise entwickelt und verbessert. Der Mensch gibt Hinweise, die KI schlägt Anpassungen vor – bis das Endergebnis steht. Dieses Verfahren eignet sich ideal für sogenannte „Losgröße 1“-Produktionen, bei denen jedes Produkt einzigartig ist. Ist das Design fertig, kann es direkt im 3D-Druck umgesetzt werden.

In dieser Demo zeigt ein mobiler Roboter, wie er sicher navigieren, mit Menschen interagieren und seine Umgebung erkennen kann. In einem praxisnahen Szenario – übertragbar auf industrielle Anwendungen – fährt der Roboter zu einem Zielort, greift ein Objekt und wirft es kontrolliert an einen definierten Platz. Der Wurf erfolgt mithilfe eines elastischen Greifers und eines speziellen pneumatischen Werkzeugs. Eine menschenähnliche Roboterfigur dient als „Fahrerdummy“ und veranschaulicht die Interaktion mit dem Menschen. Eine zweite Roboterplattform demonstriert verbesserte Wurffähigkeiten durch einen speziell entwickelten elastischen Greifarm.

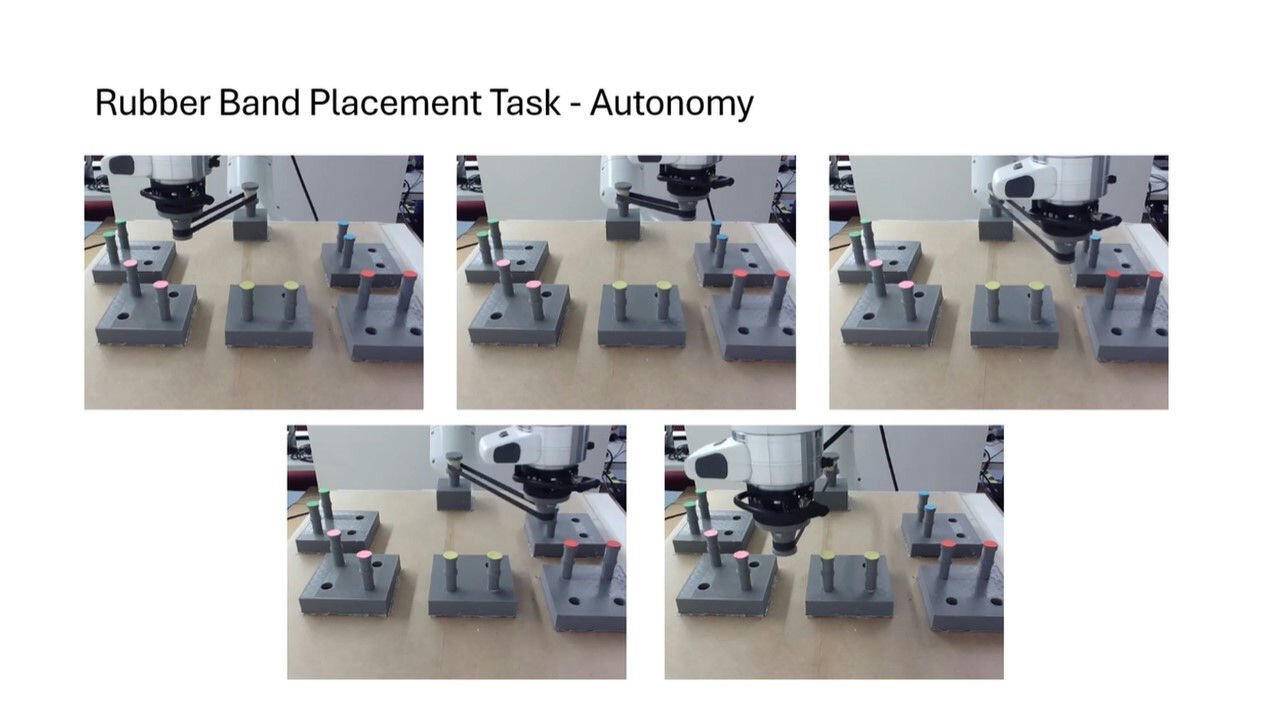

Diese Demo zeigt eine Fernlernplattform, bei der ein Roboter eine präzise Aufgabe – das Platzieren eines Gummibands. Die Steuerung erfolgt aus der Ferne mit taktilem Feedback, selbst bei simulierten Internetverzögerungen. Der Roboter nutzt die erlernten Fähigkeiten anschließend, um die Aufgabe selbstständig auszuführen. Ziel ist es zu zeigen, wie Roboter auch unter Zeitverzögerung durch Teleoperation lernen können. Das System basiert auf dem IEEE P1918.1.1 Standard und nutzt moderne Methoden, um eine sichere und realistische Steuerung zu gewährleisten.

DeepSynergy.AI präsentiert eine innovative KI-basierte Lösung für eine intelligentere Produktionsplanung. Die Demo zeigt, wie das System automatisch komplexe Produktionspläne erstellt und optimiert – durch die Analyse von Echtzeitdaten aus der Fabrik. Die Software hilft Unternehmen, schneller auf Veränderungen zu reagieren, Engpässe zu vermeiden und Ressourcen besser zu nutzen.

Unser Exoskelett ist eine Revolution! Es nutzt starke Stahlseile, die von Elektromotoren am Rücken angetrieben werden, um die Arme bei körperlicher Arbeit zu entlasten. Eine textile Struktur stützt zusätzlich den Rücken. Das intelligente System wurde entwickelt, um die Belastung für Mitarbeitende in Logistik und Produktion zu reduzieren. Es hält sie gesund, motiviert und leistungsfähig – den ganzen Tag über.

Besuchen Sie uns am Stand und erleben Sie den Demonstrator live!

An unserem Stand zeigen wir einen spannenden Prototyp: einen humanoiden Unterkörper-Roboter, der stehen – und im besten Fall – sogar gehen kann. Unser Ziel? Den schnellsten humanoiden Roboter der Welt zu bauen! Inspiriert vom BirdBot des Max-Planck-Instituts nutzt unser Roboter ein besonderes, naturinspiriertes Beindesign. So kann er sich schnell und energieeffizient bewegen – auch im unwegsamen Gelände. Im Gegensatz zu anderen Robotern für Innenräume ist unserer für echte Herausforderungen gemacht: Rettungseinsätze, Logistik oder Mobilität. Durch KI und sogenanntes Reinforcement Learning lernt der Roboter, sich flüssig und flexibel zu bewegen. Unsere Vision: ein Sprint über 100 Meter mit über 15 km/h!

Diese Demo zeigt einen zweibeinigen Roboter, der dank lernbasierter Steuerung laufen und Aufgaben ausführen kann. Im AI.Society-Bereich bewegt sich der Roboter selbstständig durch den Hauptgang und interagiert auf spannende Weise mit den Besuchern. Er trägt einen Korb, aus dem er Flyer zu MIRMI-Projekten verteilt oder kleine 3D-gedruckte Geschenke wie Schlüsselanhänger oder Flaschenöffner mit MIRMI-Logo überreicht. Außerdem können Besucher den Roboter bitten, sie gezielt zu bestimmten Messeständen zu führen.

Zukunftsfeld Mobilität

Mobilität bewegt uns alle – im wahrsten Sinne des Wortes – und damit auch die Robotik und AI.Society. Nachhaltige und flexible Mobilitätslösungen werden unsere Zukunft prägen. Autonome Fahrzeuge, vernetzte Mobilität, fliegende Roboter, Dynamikmodellierung und Kollisionserkennung sind wesentliche Bestandteile der mobilen Robotik. Darüber hinaus erleichtert uns KI den Zugang zu neuen Mobilitätsformen und hilft uns, menschliche Fehler auszuschließen.

SHOWCASES MOBILITY 2025

Wir haben eine teilautomatisierte Rikscha entwickelt – ein innovativer Ansatz für urbane Mobilität. Im Vergleich zu anderen autonomen Fahrzeugprototypen ist sie deutlich kostengünstiger und einfacher aufgebaut, nutzt aber dennoch typische Soft- und Hardwarekomponenten automatisierter Systeme. Die reduzierte Komplexität ermöglicht schnelle Tests und Weiterentwicklungen. Aufgrund ihrer kompakten Bauweise kann die Rikscha theoretisch auch auf Radwegen oder in für Autos gesperrten Bereichen wie dem Englischen Garten fahren. So entstehen neue Einsatzmöglichkeiten für den umweltfreundlichen und effizienten Transport von Personen und Gütern im städtischen Raum.

Für blinde Menschen ist das Gehen im Freien oft mit Hindernissen verbunden. Der weiße Stock hilft, erkennt jedoch nicht alle Gefahren. SmartAIs ist eine benutzerfreundliche Smartphone-App, die mithilfe von Künstlicher Intelligenz, Computer Vision und den Sensoren des Handys die Umgebung in Echtzeit analysiert. Sie erkennt Hindernisse und zeigt sichere Wege. Wird ein Objekt erkannt, gibt die App über Kopfhörer Töne oder gesprochene Hinweise aus. Die Anwendung läuft vollständig auf dem Smartphone, das sicher in einer speziell entwickelten Brusttasche getragen wird.

Zukunftsfeld Gesundheit

Viele Roboter, die zuvor in der Industrie eingesetzt wurden, werden nun angepasst, um den anspruchsvolleren Herausforderungen des Gesundheitssektors gerecht zu werden. Die Gründe? Eine immer älter werdende Bevölkerung und der Mangel an medizinischem Fachpersonal. Computer Vision, maschinelles Lernen, Virtual und Augmented Reality u. a. werden die Robotik zukünftig auf ein völlig neues Niveau heben, so dass sie zu echten Mitarbeitern werden können.

SHOWCASES HEALTH 2025

Unsere Hände sind unverzichtbar – zum Greifen, Fühlen und zur Kommunikation. Der Verlust der feinen Bewegungsfähigkeit von Arm oder Hand stellt Betroffene vor große medizinische und emotionale Herausforderungen. Moderne Prothesen können helfen, manche Fähigkeiten zurückzugewinnen, doch viele Nutzer empfinden die aktuellen technischen Lösungen noch als unzureichend.

An unserem Stand zeigen wir neue Ansätze für intelligentere, benutzerfreundlichere Prothesenhände. Zu sehen sind sowohl marktverfügbare Roboterhände als auch innovative Prototypen aus weichen Materialien. Außerdem laden wir Besucher ein, verschiedene Steuerungsmethoden in virtueller Realität auszuprobieren. Unser Ziel: Prothesen, die sich natürlicher anfühlen und den Alltag besser unterstützen.

Diese motorisierte Prothese der nächsten Generation ist darauf ausgelegt, sich natürlicher zu bewegen und besser auf die Bedürfnisse der Nutzer einzugehen. Sie kombiniert moderne Funktionen wie flexible Gelenkbewegung, anpassungsfähige Interaktion mit Objekten und Schwerkraftkompensation zur Entlastung. Alle Bauteile – Motoren, Sensoren und ein kompakter Bordcomputer – sind in einem schlanken Design vereint und ermöglichen eine präzise Steuerung im Alltag. Das System lässt sich mit einer spezialisierten Roboterhand kombinieren und bietet so eine umfassende Lösung für den gesamten Arm.

An unserem Stand zeigen wir, wie sich die Prothese flexibel an verschiedene Aufgaben und Greifkräfte anpasst. Der Fokus liegt auf Komfort, Funktionalität und Alltagstauglichkeit. Durch den Einsatz moderner Robotik ebnet diese Innovation den Weg für zukünftige Verbesserungen und erleichtert das Leben mit einer Prothese.

Diese Demo zeigt, wie Muskelsignale aus dem Arm (EMG) genutzt werden, um einen Roboterarm mit sieben Gelenken und einem Zwei-Finger-Greifer zu steuern. Die Bewegungen des Arms sind vorprogrammiert, doch der Nutzer bestimmt über seine Muskelaktivität, wann und wie der Roboter zugreift. Besucher sehen, wie das System verschiedene Aufgaben bewältigt – vom Greifen unterschiedlich geformter Objekte bis zum Falten eines Tuchs und dem Einsatz eines roboterhaften Hand-Werkzeugs. Diese Technik verbindet menschliche Absicht mit der Präzision von Robotik. Unsere Forschung verbessert die Verarbeitung der EMG-Signale, um das System zuverlässiger, anpassungsfähiger und benutzerfreundlicher zu machen. Ziel ist eine natürlichere und effektivere Interaktion zwischen Mensch und Roboter im Alltag.

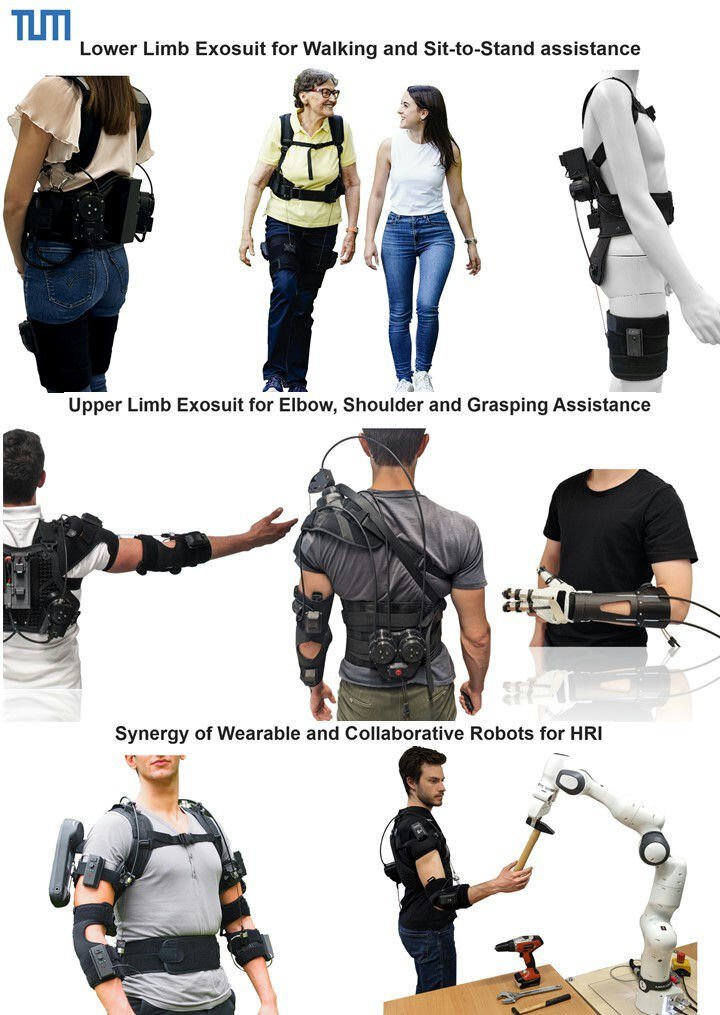

Diese Demo zeigt weiche, tragbare Exosuits, die natürliche Körperbewegungen unterstützen und verstärken. Die leichten, stoffähnlichen Systeme nutzen Seilzüge, um gezielt Muskeln bei Arbeit und Rehabilitation zu entlasten. Gezeigt werden unter anderem ein Ellenbogen-Exosuit zur Armunterstützung, ein Schulter-Exosuit, ein Hüft-Exosuit für leichteres Gehen und ein Exohandschuh für Finger- und Handgelenksbewegung. Die Geräte passen sich mithilfe von Echtzeitsteuerung und individuell angepassten Bewegungsmodellen an den Nutzer an. Ein kollaborativer Roboter demonstriert zusätzlich, wie Mensch und Roboter sicher im Team arbeiten können. Ob in der Therapie oder in der Industrie – diese Exosuits bieten neue Möglichkeiten zur Verbesserung der Mobilität, zur Entlastung der Muskulatur und zur Steigerung der Leistungsfähigkeit im Alltag.

Diese Demo zeigt, wie Roboter einer älteren Person bei alltäglichen Aufgaben helfen können, insbesondere wenn es schwierig ist, mehrere Dinge gleichzeitig zu halten oder zu erreichen. Mit Hilfe einer Kamera beobachtet das System, was eine Person tut, und versteht die Tätigkeit automatisch mit Hilfe von Computer Vision. Dann findet der Roboter heraus, welcher zusätzliche Gegenstand benötigt wird und nimmt ihn mit einem Roboterarm auf, um ihn zu übergeben. Nimmt die Person zum Beispiel eine Zahnbürste in die Hand, übergibt der Roboter die Zahnpasta.

Unsere Demo zeigt ein fortschrittliches System zur Mensch-Roboter-Kollaboration für Assistenz- und Alltagsanwendungen. Auf der automatica – Munich_i 2025 präsentieren wir den weiterentwickelten GARMI: einen humanoiden Roboter, der seine Höhe anpassen und direkt mit Menschen interagieren kann. GARMI kombiniert Echtzeitplanung, adaptive Bewegungssteuerung und zertifizierte Sicherheitsfunktionen, um bei alltäglichen Aufgaben zu helfen. Er erkennt menschliche Aktivitäten, sagt Handlungen voraus und reagiert entsprechend. Mit Technologien wie Sprachverarbeitung, visueller Wahrnehmung und digitalen Zwillingen versteht GARMI Aufgaben, führt Übergaben durch und lernt aus Demonstrationen. Die Demo unterstreicht die interdisziplinäre Forschung der TUM im Bereich Assistenzrobotik – ein Beitrag zur Lösung von Fachkräftemangel und zur sicheren, intuitiven Zusammenarbeit von Mensch und Roboter. Zusätzlich zeigen wir Einzelarbeiten mehrerer TUM-Lehrstühle in einer integrierten Präsentation.

Unsere Demo zeigt die Vision von GARMI – einem Roboter, der den Alltag und die Gesundheitsversorgung unterstützen soll. Besucher erleben Aufgaben, die GARMI selbstständig oder aus der Ferne gesteuert ausführt. Die wichtigsten Demos:

Fern-Ultraschall: Ein Arzt führt per Fernsteuerung eine Ultraschalluntersuchung mit GARMI durch.

Pflegehilfe: GARMI bewegt einen medizinischen Wagen selbstständig und unterstützt bei Transport und Logistik.

Objektmanipulation: Der Roboter greift und bewegt verschiedene Gegenstände präzise und sicher.

Telepräsenz-Steuerung: Mit Roboterarmen kann GARMI in Echtzeit ferngesteuert werden – sogar bei kleiner Internetverzögerung.

Diese Anwendungen zeigen, wie GARMI Pflegekräfte entlasten, die Versorgung verbessern und auch in abgelegenen Regionen helfen kann.

Im Forschungsprojekt SASHA-OR wird ein intelligenter Assistenzroboter für den direkten Einsatz am OP-Tisch entwickelt. Der Roboter ist für den sterilen Bereich konzipiert und unterstützt das OP-Team bei der flexiblen Handhabung von Instrumenten und Materialien. Mit Hilfe moderner Tastsensoren und Bilderkennung kann er Werkzeuge erkennen, verbal mit dem OP-Team interagieren und laparoskopische Instrumente sowie sterile Güter sicher übergeben und entgegennehmen.

Unbemannter medizinischer Transport ist die Zukunft der Notfallversorgung in gefährlichen oder schwer zugänglichen Gebieten. Im EU-geförderten Projekt iMEDCAP wird eine Strategie entwickelt, um Patienten während des Transports ohne medizinisches Personal zu versorgen. Eine seltene, aber lebensbedrohliche Komplikation ist der Spannungspneumothorax. Mit Ärzten an Bord kann er leicht behandelt werden – ohne Hilfe endet er meist tödlich. Deshalb wurde das weltweit erste Robotermodul zur Entlastung eines Spannungspneumothorax entwickelt. Dieses System führt automatisch eine Nadelentlastung durch – gesteuert durch Ultraschall in Echtzeit. Ein entscheidender Fortschritt, um Leben zu retten, wenn kein medizinisches Fachpersonal vor Ort ist.

In vielen Regionen der Welt ist der Zugang zu medizinischer Versorgung eingeschränkt – durch fehlende Infrastruktur und Mangel an Fachpersonal. Unsere teilautonome, telerobotische Untersuchungsstation soll diese Lücke schließen, indem sie eine medizinische Telepräsenz und präzise Diagnostik aus der Ferne ermöglicht. Ärzte können so Patienten untersuchen, ohne vor Ort zu sein – sicher und zuverlässig. Das System vereint verschiedene medizinische Verfahren, berücksichtigt Notfälle und stellt die Patientensicherheit in den Mittelpunkt. Zudem dient es als Testplattform für heutige Netzwerke und die Anforderungen künftiger 6G-Technologien.

Diese Demo zeigt Forschung und Entwicklung in der Telechirurgie, bei der Operationen aus der Ferne mithilfe von Robotern durchgeführt werden. Die Plattform besitzt eine offene Steuerungsstruktur, die flexible Weiterentwicklung ermöglicht. Chirurginnen erhalten ein taktiles Echtzeit-Feedback, das ihnen ein realistisches Tastgefühl bei Eingriffen auf Distanz vermittelt. Intelligente Kontrollstrategien helfen dabei, Zeitverzögerungen in der Datenübertragung auszugleichen. KI unterstützt den Ablauf mit geteilter oder überwachter Autonomie. Für eine stabile und schnelle Verbindung kommen moderne 5G- und zukünftige 6G-Netzwerke zum Einsatz. Ein integriertes Online-Sicherheitssystem sorgt dafür, dass bei Netzwerkstörungen kein Risiko für Patientinnen entsteht.

Zukunftsfeld Umwelt

Zu unseren dringlichsten Problemen gehört der Bereich Klima und Umwelt. Wie können KI und intelligente Roboter dazu beitragen, diese große globale Herausforderung gezielt anzugehen? In der nachhaltigen Landwirtschaft, beim Umweltschutz und zur Messung der Luftqualität kommen bereits verschiedene Anwendungen zum Einsatz.

SHOWCASES ENVIRONMENT 2025

Unsere Demo zeigt, wie Robotik als Service Umweltforschung unterstützen kann. Im Mittelpunkt steht der SVan – ein mobiles Zentrum zur Steuerung und zum Einsatz von Robotern. Besucher können Aufgaben wie Wasserqualitätsmessung oder Bodenproben definieren, die von einem Bodenroboter mit Greifarm ausgeführt werden – autonom oder mit Nutzerunterstützung. Eine stationäre Drohne liefert eine Vogelperspektive und veranschaulicht die Zusammenarbeit verschiedener Robotertypen. Zusätzlich demonstriert der Unterwasserroboter BlueROV2 seine Fähigkeiten zur Inspektion und Manipulation unter Wasser.

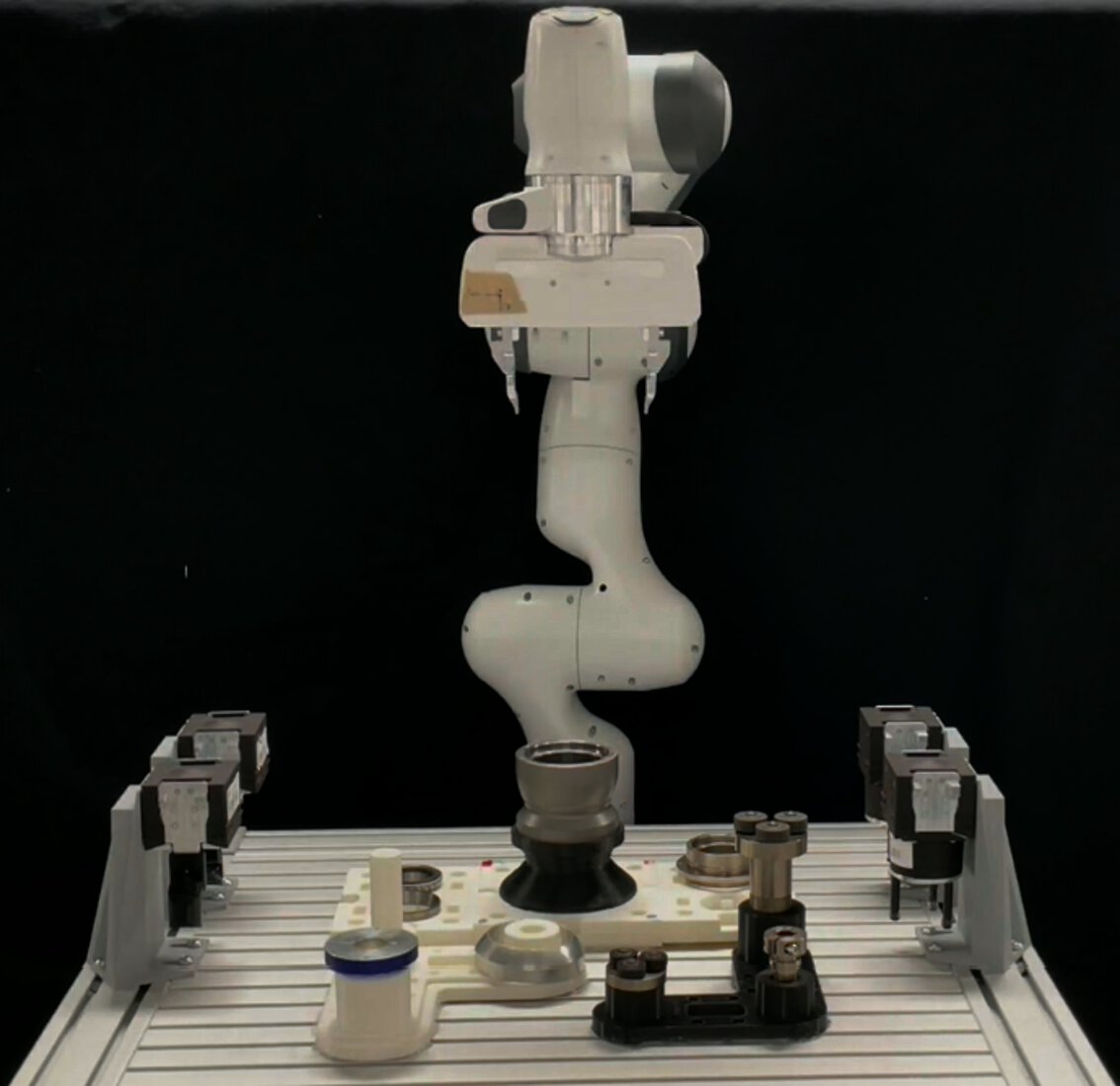

Diese Demo zeigt die Gewinnerlösung der euROBIN Manipulation Skill Versatility Challenge mit dem Franka Panda-Roboter und einem elektronischen Aufgabenboard der IROS 2024. Gezeigt werden vielseitige Roboterfähigkeiten wie Objekterkennung, das Einsetzen von Stiften, Türöffnen, Kabelwickeln und das Testen elektrischer Schaltungen. Diese Aufgaben sind zentral für eine flexible, intelligente Automatisierung. Die Präsentation ergänzt die neue Robothon Grand Challenge und gibt Einblick in erfolgreiche Lösungen früherer Wettbewerbe. Der Roboter von MIRMI führt die Aufgaben mit dem Beitrag des TU Delft-Teams aus.

Datum | Dienstag, 24. Juni bis Freitag, 27. Juni 2025 |

Uhrzeit | Täglich 09:00 - 17:00 (Dienstag-Donnerstag) bzw. 16:00 (Freitag) |

Ort | Halle B4 Stand 329 |

Sprache | Englisch |